[ADsP] 3과목 정리 (회귀 분석 개요)

- 용어 정리

- 독립변수

= 다른 변수에 영향을 받지 않고 독립적으로 변화하는 수, 설명 변수라고도 함

= 입력값이나 원인을 나타내는 변수, y= f(x) 에서 x에 해당하는 것

- 종속변수

= 독립변수의 영향을 받아 값이 변화하는 수, 분석의 대상이 되는 변수

= 결과물이나 효과를 나타내는 변수, y= f(x) 에서 y 에 해당하는 것

- 잔차 (오차)

= 계산에 의해 얻어진 이론 값과 실제 관측이나 측정에 의해 얻어진 값의 차이

= 모집단- 오차 (Error), 표본집단- 잔차 (Residual)

회귀 분석

- 변수와 변수 사이의 관계를 알아보기 위한 통계적 분석 방법

- 독립변수의 값에 의해 종속변수의 값을 예측하기 위한 분석 방법

- 일반 선형회귀는 종속변수가 '연속형 변수일 때 가능함'

- 명목, 서열척도- 이산형(범주형), 구간, 비율척도- 연속형

선형회귀모형

- 종속변수 y와 한 개 이상의 독립변수 x와의 선형 상관관계를 모델링하는 회귀 분석 기법

- 한 개의 독립변수: 단순선형회귀/ 둘 이상의 독립변수: 다중선형회귀

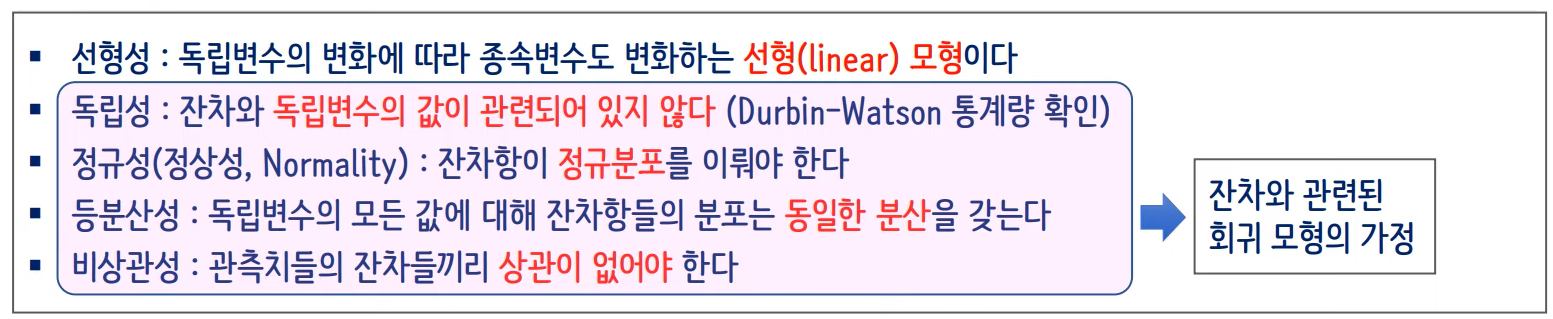

회귀 모형의 가정

- 선형성: 독립변수의 변화에 따라 종속변수도 변화하는 선형 모형이다

[잔차와 관련된 회귀 모형의 가정]

- 독립성: 잔차와 독립변수의 값이 관련되어 있지 않다 (Durbin- Waston 통계량 확인)

- 정규성(정상성, Normality): 잔차항이 정규분포를 이뤄야 한다

- 등분산성: 독립변수의 모든 값에 대해 잔차항들의 분포는 '동일한 분산' 을 갖는다

- 비상관성: 관측치들의 잔차들끼리 상관이 없어야 한다

[잔차와 잔차항]

- 잔차: 실제 관측값과 예측값 간의 차이

- 잔차항: 회귀모델의 오차항으로 잠재적인 오차를 의미함

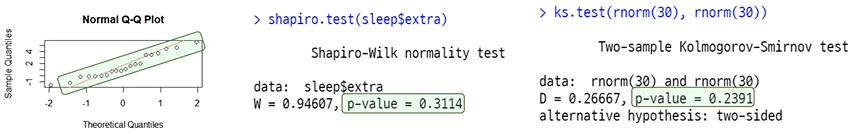

- 모델 진단 그래프- Normal Q-Q, Scale-Location

[Normal Q-Q plot]

- 정규성(정상성), 잔차가 정규분포를 잘 따르고 있는지를 확인하는 그래프

- 잔차들이 그래프 선상에 있어야 이상적인 (정규성을 갖움)

- 그래프에서 숫자와 함께 표시된 것들은 이상치를 의미함

[Scale- Location]

- 등분산성, y축이 표준화 잔차를 나타내며, 기울기 0인 직선이 이상적임 (등분산성을 갖음)

- 모델 진단 그래프- Residuals vs Fitted: 선형성, 등분산성에 대해 알아볼 수 있는 그래프

- 선형성: y값의 기울기가 0인 직선이 이상적

- 등분산성: 점의 위치가 전체 그래프에 고르게 분포하는 것이 이상적

데이터의 정규성 검정 방법:

Normal Q-Q plot, Histogram, Shapiro Wilk test, Kolmogrov-Smirnov test, Anderson- Darling test

[Normal Q-Q plot]

- 그래프를 그려서 정규성 가정이 만족되는지 '시각적으로 확인하는 방법'

- 대각선 참조선을 따라 값들이 분포하게 되면 정규성을 만족한다고 할 수 있음

[Histogram]

- 구간별 돗수를 그래프로 표시하여 '시각적으로 정규분포를 확인' 하는 방법

[Anderson- Darling Test]

- 데이터가 특정 분포를 따르는 지 확인하는 '적합도 검정 방법'

- 귀무가설: 데이터는 특정 분포를 따른다

- 대립가설: 데이터는 특정 분포를 따르지 않는다

- K-S Test 를 수정한 적합도 검정으로 특정 분포의 꼬리에 K-S Test 보다 가중치를 더 두어 수행됨

단순 회귀 분석

- 최소자승법

-> y= f(x) 의 측정값 y 와 함수값 f(x) 의 차이를 제곱한 것의 합이 최소가 되도록 y= f(x)를 구하는 것

-> y= ax + b 일 때 잔차를 제곱한 것의 합이 최소가 되도록 하는 상수 a, b 를 찾는 것

-> 즉, (측정값- 함수값)^2 의 합이 최소가 되는 직선의 그래프를 찾는 것

-> 큰 폭의 잔차에 대해 보다 더 큰 가중치를 부여하여, 독립변수 값이 동일한 평균치를 갖는 경우 가능한 한 변동 폭이 적은 표본회귀선을 도출하기 위한 것

- 표본 회귀선의 유의성 검정

- 두 변수 사이에 선형관계가 성립하는지 검정하는 것

- 귀무가설: 회귀식의 기울기 계수 B 은 0과 같다./ 대립가설: 회귀식의 기울기 계수 B은 0과 같지 않다

- 회귀모형의 해석

- 결정계수

- 결정계수 (R^2) = 회귀제곱합 (SSR)/ 총제곱 (SST), 1- (SSE/ SST)

- 회귀식의 적합도를 재는 척도

- 결정계수는 0~1 사이의 범위를 갖으며, 결정계수가 커질수록 회귀방정식의 설명력이 높아짐

- 전체 분산 중 모델에 의해 설명되는 분산의 양

- 회귀 모형의 분산 분석

- 결정계수 = SSR/ SST, speed의 Sum Sq 값이 SSR 이고, Rediduals 의 Sum Sq 값이 SSE 이다,

- 결정계수= SSR/ (SSR + SSE) = ((21186 + 11354)) = 0.651

- F-value 의 p-value 를 보면 1.49e -12 로 통계적 유의미를 갖음 (회귀계수는 5% 수준에서 유의미함)

- MSE 는 오차 분산의 불편추정량 (오차제곱평균)으로, Residuals 의 Mean Sq 값인 236.5

- 데이터의 개수는 n = df + 1, speed 의 df, Rediuals 의 df 을 모두 더한 값에 1을 더하여 구함, n= (1+48) +1 =50

다중공선성 (Multicollinearity) 의 이해

설명변수 선택 방법

[모든 가능한 조합]

- 모든 가능한 독립변수들의 조합에 대한 회귀모형을 고려해 AIC, BIC 의 기준으로 가장 적합한 회귀 모형 선택

- AIC, BIC: 최소자승법의 R^2 와 비슷한 역할을 하며, 적합성을 측정해주는 지표로, R^2는 큰 값이 좋지만, AIC, BIC 는 작은 값이 좋음

[후진제거법]

= Backward Elimination , 독립변수 후보 모두를 포함한 모형에서 출발해 제곱합의 기준으로 가장 적은 영향을 주는 변수로부터 '하나씩 제거' 하면서 더 이상 유의하지 않은 변수가 없을 때까지 설명변수를 제거하고, 이때 모형을 선택함

[전진선택법]

= Forward Selection, 절편만 있는 모텔에서 출발해 기준 통계치를 가장 많이 개선시키는 변수를 차례로 추가하는 방법

[단계별 선택법]

= Stepwise Method, 모든 변수가 포함된 모델에서 출발 또는 절편만 있는 모델에서 출발해 기준 통계치에 가장 도움이 되지 않는 '변수를 삭제하거나', 모델에서 빠져 있는 변수 중에서 기준 통계치를 가장 개선시키는 '변수를 추가'하는 방법

- 회귀모델에서 변수 선택을 위한 판단 기준 -> Mallow's Cp, AIC, BIC 등이 있으며, 값이 작을수록 좋음

과대적합과 과소적합

[과소적합]

- 모델이 너무 단순하거나 훈련 데이터를 충분히 학습하지 못할 때 발생함

- 모델이 훈련 데이터에 대해 충분한 패턴을 학습하지 못하므로, 테스트 데이터에서도 성능이 좋지 않음

- 일반화 능력이 부족하며, 새로운 데이터에 대한 예측이 부정확할 수 있음

- 학습을 좀 더 진행하여 예측력을 높여 성능을 높여야 함

[과대적합]

- 모델이 훈련 데이터에 지나치게 적합되어 훈련 데이터에 존재하는 잡음까지 학습한 경우에 발생함

- 훈련 데이터에 대한 예측은 우수하지만, '새로운 데이터나 테스트 데이터에서는 성능이 떨어질 수 있는 상태'이다

- 모델이 훈련 데이터의 특정 패턴이나 노이즈에 과도하게 민감하게 반응하는 경향이 있음

- 학습을 방해하는 요소를 추가하여 과대적합을 해결해서 학습 데이터의 성능과 평가 데이터의 성능 차이가 많지 않도록 조정해야 함

[과대적합 문제와 해결 방법]

- 주어진 샘플들의 설명변수와 종속변수의 관계를 필요 이상 너무 자세하고 복잡하게 분석하여 발생함

- 샘플에 심취한 모델로 새로운 데이터가 주어졌을 때 제대로 예측해내기 어려울 수 있음

- 해결 방법으로 독립변수의 개수를 줄이거나, 정칙화를 수행하는 방법이 있음

[정칙화 (= 정규화, 규제, Regularization) 개념]

- 베타(B) 값에 제약 (penalty)을 주어 모델에 변화를 주는 방법

- 람다 값은 정규화 모형을 조정하는 hyper parameter

- 람다 값이 클수록 제약이 많아져 적은 변수가 사용되고, 해석이 쉬워지지만 underfitting

- 람다 값이 작아질수록 제약이 적어 많은 변수가 사용되고, 해석이 어려워지며 overfitting 됨

- 람다는 '알파'라는 기호로 사용되기도 함

[ norm: 선형대수학에서 벡터의 크기 (magnitude) 또는 길이 (length)를 측정하는 방법 ]

- L norm (= Manhattan norm)